5月 25 日,特斯拉官方博客宣布,Autopilot 正在过渡到基于摄像头的 Tesla Vision 系统。

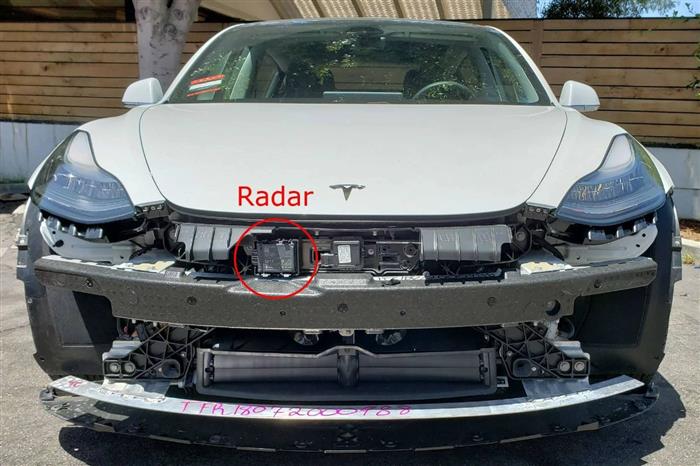

从 2021 年 5 月起,北美制造的 Model 3 和 Model Y 将不再配备毫米波雷达,这些车型将通过特斯拉的摄像头视觉和深度神经网络来支撑 Autopilot、FSD 完全自动驾驶和某些主动安全功能。

单价约 300 人民币的前向雷达,超 45 万辆/年(2020 年数据)的销量规模,对于特斯拉的毫米波雷达供应商、顶级 Tier 1 供应商大陆集团而言,中途丢掉一年过亿的订单实在不是个令人愉悦的消息。

去掉毫米波雷达

尽管特斯拉明确说明,计算机视觉和深度神经网络处理将实现主动安全/ Autopilot / FSD 的感知需求,但博客一出,各方立刻应声而动。

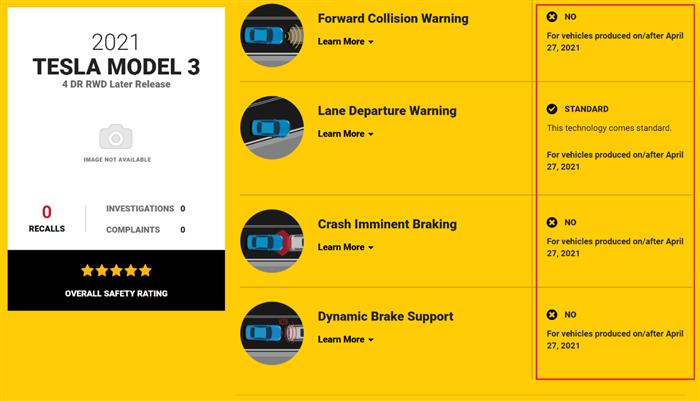

美国高速公路安全管理局(NHTSA)官网修改了 2021 款 Model 3 和 Model Y 的主动安全功能页面,包括前向防撞预警(FCW)、防撞自动刹车(CIB)、动态制动辅助(DBS)均被明确提示,2021 年 4 月 27 日后生产的车型不再配备。

与此同时,《消费者报告》宣布暂停将 2021 款 Model 3 列为「推荐」,美国高速公路安全保险协会(IIHS)取消了 Model 3 曾经 Top Safety Pick + 的最高安全评级。

与此同时,《消费者报告》宣布暂停将 2021 款 Model 3 列为「推荐」,美国高速公路安全保险协会(IIHS)取消了 Model 3 曾经 Top Safety Pick + 的最高安全评级。

简单总结,特斯拉说我们移除了毫米波雷达,并通过摄像头实现了雷达之前的能力,但所有人都只听到了前半句。

在我看来,各大民间和监管的安全机构如今对特斯拉都有些过敏,事实上,如果我们去梳理全球第一大视觉感知供应商 Mobileye 这些年的耕耘,正是一个将雷达逐步移出汽车主动安全范畴的发展史。

2007 年,Mobileye 主动安全技术首次进入汽车行业。

2010 年,融合雷达和摄像头的 Mobileye AEB 搭载在沃尔沃品牌量产。

2011 年,Mobileye 纯视觉前向防撞预警(FCW)在宝马、通用和欧宝品牌量产。

2013 年,Mobileye 纯视觉车辆和行人自动紧急制动(AEB)在宝马和日产品牌量产。

2013 年,Mobileye 纯视觉自适应巡航控制(ACC)在宝马品牌量产。

2015 年,Mobileye 纯视觉全功能 AEB 进入多个 OEM。

但事情正在愈演愈烈。特斯拉 CEO Elon Musk 不得不通过 Electrek 辟谣:所有的主动安全功能都在新下线的车型中有效,NHTSA 会在下周对新车型进行重新测试,当前移除雷达的车型是标配这些功能的。

但公众的质疑并没有被打消。比如,雷达擅长的对障碍物距离和速度的测量,恰恰是摄像头的传统弱势项目,特斯拉如何解决?

又或者,两种传感器怎么也比一种传感器好吧,即使摄像头可以做雷达所做的工作,两种传感器一起检测不好吗?

下面我们就来聊聊这些问题。

计算机视觉 + RNN > 雷达 ?

我们需要先了解雷达的技术原理,以及其在自动驾驶中所扮演的角色。

毫米波(Millimeter-Wave)雷达,通过发射电磁波信号,接收目标反射信号来获得车身周围其他障碍物的相对速度、相对距离、角度、运动方向等。

通过对上述这些信息的处理,汽车得以配备一系列的主动安全功能,如自适应巡航控制(ACC)、前向防撞预警(FCW)、辅助变道(LCA)、自动跟车(S&G)甚至盲区检测(BSD)等。

那么,特斯拉又如何通过摄像头获得上述信息的呢,比如,对前车距离的判断?

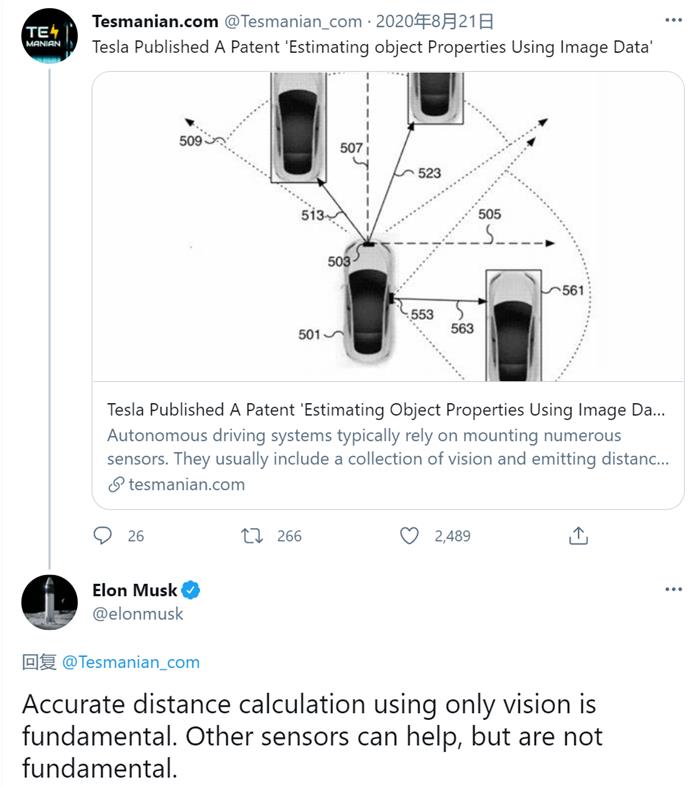

2020 年 8 月 21 日,Elon 在 Twitter 上表示,通过纯视觉进行准确的距离计算是基础,其他传感器可以提供帮助,但那不是基础。他所回复的博文,介绍的正是特斯拉一项名为《Estimating object Properties Using Image Data(使用视觉数据估算对象属性)》的专利。

4月 13 日,特斯拉 Model 3 车主、Facebook 分布式 AI 和机器学习软件工程师 Tristan Rice「黑」进了 Autopilot 的固件,揭开了特斯拉通过机器学习取代雷达的技术细节。

根据 Tristan 的说法,从新固件的二进制文件中可以看出,Autopilot 的深度神经网络增加了许多新的输出,除了现有的 xyz 输出外,还包括许多传统雷达输出的数据,例如距离、速度和加速度等等。

深度神经网络可以从一张静态的图片中读取速度和加速度吗?当然不行。

特斯拉训练了一个高度精确的 RNN,通过 15 帧照片/秒的、基于时间序列的视频来预测障碍物的速度和加速度。

RNN又是什么?RNN 的关键词是预测。Recurrent Neural Network,循环神经网络,顾名思义,基于环状神经网络传递和处理信息,通过「内部记忆」来处理任意时序的输入序列,以准确预测接下来即将发生的事情。

英伟达的 AI 博客曾举过一个经典的例子:假设餐厅供应是菜品规律是不变的,周一汉堡、周二炸玉米饼、周三披萨、周四寿司、周五意面。

对于 RNN 而言,输入寿司并寻求「周五吃什么」的答案,Ta 将会输出预测结果:意面。因为 RNN 已经知道这是一个顺序,而周四的菜品刚刚完成,因此接下来是周五的菜品是——意面。

对于 Autopilot 的 RNN 来说,给到当前汽车周围的行人、车辆和其他障碍物的移动路径,RNN 就可以预测接下来的移动轨迹,包括位置、速度和加速度。

事实上,在 5 月 25 日正式官宣移除雷达的前几个月,特斯拉一直在将其 RNN 与全球车队中的雷达并行运行,通过雷达输出的正确数据和 RNN 输出结果校对,来提升 RNN 预测的准确性。

多说一句,对于中国交通工况下非常经典的加塞儿处理,特斯拉也通过类似的路线更替实现了更好的表现。

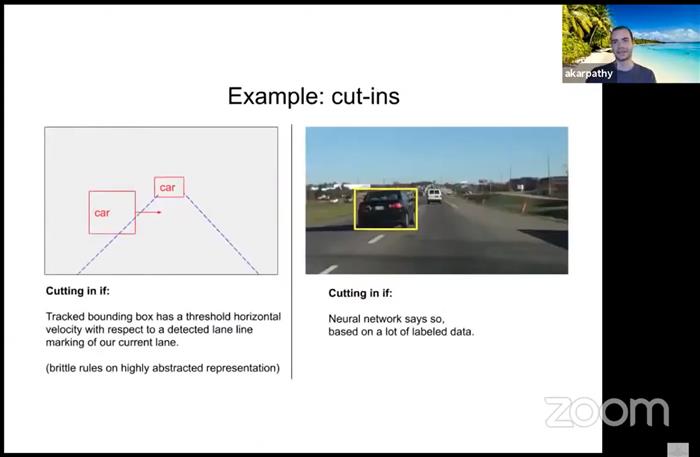

特斯拉 AI 高级总监 Andrej Karpathy 在 CVPR 2021 的一次线上演讲中透露,对于前车加塞儿(Cut-ins)识别,特斯拉已经通过深度神经网络完成对传统规则算法的替换。

具体来说,Autopilot 此前检测加塞儿基于一个写死的规则:首先要识别车道线,同时识别和跟踪前方的车辆(bounding box),直到检测到前车速度出现符合加塞儿的阈值水平速度,才执行加塞儿指令。

而如今 Autopilot 的加塞儿识别移除了这些规则,完全通过 RNN 基于标注的海量数据做前车的行为预测,如果 RNN 预测前车将加塞儿,就执行加塞儿指令。

这就是过去几个月来特斯拉对加塞儿识别取得大幅改进的技术原理。

前文提到的特斯拉专利里详细解释了特斯拉训练RNN 的运作形式。

特斯拉会将雷达和激光雷达(非量产车队,特斯拉内部的 Luminar 激光雷达车队)输出的正确数据与 RNN 识别的对象相关联,以准确估计对象属性,例如对象距离。

在这个过程中,特斯拉开发了工具使得辅助数据与视觉数据的采集和关联实现了自动化,无需人工标注。此外,关联后可以自动生成训练数据用以训练 RNN,从而实现高度精确地预测对象属性。

由于特斯拉在全球的车队规模已经超过 100 万辆,特斯拉得以在海量场景数据的训练下迅速改善其 RNN 的性能。

而 RNN 一旦将预测的准确性提升到和雷达输出结果的同等水平,就会形成相对毫米波雷达的巨大优势。

这是因为特斯拉 Autopilot 只搭载了前向雷达,在城市工况下车辆各个方位乱窜的行人、骑自行车和摩托车的人很难全部准确预测。即使是正前方的、在其 45° 探测范围内的障碍物,只要两个障碍物同距离、同速度,Autopilot 此前搭载的雷达就无法分辨。

而 Autopilot 搭载的 8 颗摄像头实现了车身周围的 360 度覆盖,其编织的全车 BEV 鸟瞰神经网络可以无缝地预测全车任何一个方位的多个障碍物接下来的移动轨迹。

那特斯拉为什么不保留雷达,利用雷达和摄像头两种传感器进行双重校验呢?

ElonMusk 详细解释过他对雷达和摄像头的看法:

在雷达波长下,现实世界看起来像一个奇怪的幽灵世界。除了金属,几乎所有东西都是半透明的。

当雷达和视觉感知不一致时,你采信哪一个?视觉具有更高的精度,因此投入两倍的精力改善视觉比押注两种传感器的融合更明智。

传感器的本质是比特流。摄像头比特/秒的信息量要比雷达和激光雷达高几个数量级。雷达必须有意义地增加比特流的信号/噪声,以使其值得集成。

随着视觉处理能力的提高,摄像头的性能将会远远甩开当下的雷达。

这番表态看起来十分微妙。我们此前的文章《特斯拉:我为激光雷达代言》一文中曾经写到过 Elon Musk 对毫米波雷达的态度。在上面这番言论中,他同样没有「宣判」雷达在特斯拉的死刑。

「雷达必须有意义地增加比特流的信号/噪声,以使其值得集成。」即将到来的特斯拉 Autopilot 会搭载成像雷达吗?